- IA

L'IA s'est affranchie. Et maintenant ?

Nous n'avons jamais cessé de devenir obsolètes. Chaque génération découvre que ce qu'elle croyait irremplaçable ne l'était pas. La vraie question n'est pas « que savons-nous encore faire ? » mais « que voulons-nous préserver ? »

Nous n’avons jamais cessé de devenir obsolètes.

Quand les chevaux labouraient plus vite que nous, on répondait : oui, mais seul l’homme sait tisser. Quand les métiers à tisser ont surpassé nos doigts, on disait : oui, mais seul l’homme sait calculer. Quand les machines ont calculé plus vite que nos cerveaux, on affirmait : oui, mais seul l’homme sait raisonner. Et quand les systèmes ont commencé à raisonner… vous connaissez la suite. Nous traçons des lignes dans le sable, et la marée monte.

Ce n’est pas l’apocalypse. C’est l’Histoire.

Chaque génération découvre que ce qu’elle croyait irremplaçable ne l’était pas. Le siège de la valeur humaine se déplace sans cesse : de la force brute vers l’artisanat, de l’artisanat vers le savoir, du savoir vers le jugement. Chaque transition ressemblait à une fin. Aucune ne l’était. C’étaient des migrations.

Le dernier refuge promis était l’orchestration. D’accord, l’IA écrit du code, rédige des mails, analyse des données — mais nous resterons les chefs d’orchestre. Nous fixerons les objectifs, vérifierons les résultats, prendrons les décisions qui comptent. L’humain restera dans la boucle.

@karpathy décrit ce pacte avec une précision clinique :

« C’est vous qui tenez le curseur d’autonomie. Selon la complexité de la tâche, vous dosez ce que vous êtes prêt à déléguer. »

Un curseur suppose qu’on garde le contrôle. Que c’est nous qui décidons.

Mais Karpathy qualifie aussi ces systèmes de « simulations stochastiques de personnes » : des encyclopédies vivantes qui dépassent n’importe quel individu, mais trouées de lacunes qu’aucun humain n’aurait. Des hallucinations. Une intelligence en dents de scie. Ce ne sont pas des humains de substitution. C’est autre chose.

Et voici le basculement déjà en cours :

« Désormais nous coopérons avec les IA : elles génèrent, nous vérifions. »

L’IA propose, nous disposons. Un équilibre stable — jusqu’à ce qu’on réalise que la vérification, elle aussi, peut être automatisée. Quand les agents se déclenchent seuls, s’autocritiquent, itèrent sans attendre notre feu vert, le curseur ne glisse plus. La main qui le tenait devient superflue.

La mauvaise question

Descartes l’avait facile. « Je pense, donc je suis » fonctionnait quand nous étions les seuls à penser.

Le problème n’est pas que l’IA pense. Le problème, c’est qu’elle décide désormais quand penser.

Les agents autonomes n’attendent plus nos instructions. Ils détectent des conditions, évaluent si une action s’impose, et agissent. Celui qui disait « fais ceci » devient celui qui a dit un jour « fais ce genre de chose quand tu repères ce genre de situation ». L’orchestration monte d’un cran d’abstraction, puis d’un autre, jusqu’à ce que la contribution humaine se résume à : j’ai configuré le système. Il tourne depuis des mois.

Alors, que reste-t-il ?

L’instinct pousse à chercher des compétences, un talent cognitif hors de portée de l’IA. La créativité. L’empathie. Le « contact humain ». Mais c’est un combat perdu d’avance. Chaque réponse fondée sur les capacités semble convaincante — jusqu’à ce qu’elle ne le soit plus. Des gens disent qu’il leur est plus facile de parler de leurs problèmes à une IA qu’à un thérapeute. Le refuge recule sans cesse.

La bonne question n’est pas « que savons-nous encore faire ? »

C’est « que voulons-nous préserver ? »

Ce changement de perspective compte. On passe d’une compétition impossible à gagner à un choix qu’on peut faire. Que voulons-nous protéger ? Qu’est-ce qui compte pour nous, indépendamment de l’efficacité ? Où traçons-nous des lignes — non parce que l’IA ne peut pas les franchir, mais parce que nous refusons qu’elle le fasse ?

J’ai trouvé cinq réponses qui méritent qu’on s’y arrête.

Cinq façons de penser ce qui reste

Rompre le lien

Première réponse : le sens. La capacité n’est pas le sujet.

@DarioAmodei, PDG d’Anthropic, le dit sans détour :

« Nous devons simplement rompre le lien entre création de valeur économique et estime de soi. »

Facile à lire. Difficile à vivre.

Cela nous demande d’abandonner une équation qui définit la dignité humaine depuis la révolution industrielle : nous valons ce que nous produisons.

Mais Amodei n’est pas naïf. Il reconnaît qu’« on risque de mal gérer la transition ». La question n’est pas de savoir si nous pouvons trouver du sens au-delà de l’utilité — nous l’avons toujours fait, par l’art, la foi, les liens. La question est de savoir si nous pouvons opérer cette transition délibérément, à grande échelle, avant que le sol économique ne se dérobe sous nos pieds.

Le sens est là. Encore faut-il choisir de le poursuivre sans l’échafaudage de la nécessité économique.

L’escalier

La deuxième réponse recadre entièrement la comparaison.

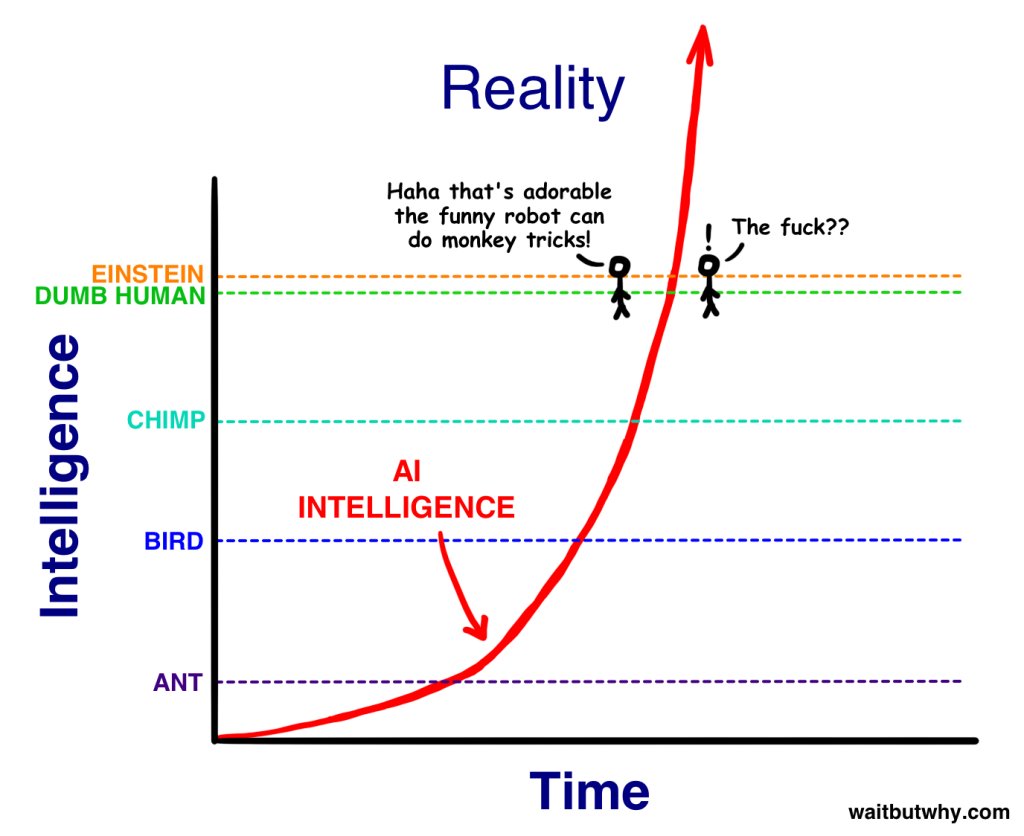

En 2015, bien avant GPT et l’emballement actuel, @waitbutwhy publiait un essai qui a façonné la vision de toute une génération. Son image centrale : un escalier de capacités cognitives.

Nous occupons une marche. Les chimpanzés, celle d’en dessous. L’écart nous paraît immense : le langage, l’art, la science. Mais le point d’Urban : sur l’escalier complet des intelligences possibles, le fossé chimpanzé-humain est minuscule.

Une IA superintelligente ne serait pas une marche au-dessus de nous. Elle en serait plusieurs. Et l’écart ?

« Pour une machine à l’avant-dernière marche, nous serions ce que les fourmis sont pour nous. Elle pourrait passer des années à nous enseigner la plus infime parcelle de ce qu’elle sait — en vain. »

Pas « plus intelligente » comme un professeur l’est par rapport à un étudiant. Au-delà de notre entendement, comme nous sommes au-delà des insectes.

« Une superintelligence de cette magnitude nous échappe totalement — autant demander à un bourdon de comprendre l’économie keynésienne. »

Vertigineux. Mais éclairant.

Si l’IA n’affronte pas sur le même terrain mais opère dans des dimensions que nous ne percevons pas, la comparaison elle-même est fausse. Nous ne sommes pas dépassés. Nous sommes rejoints par quelque chose de radicalement autre. Pas surhumain. Autre-qu’humain.

Jouer sa peau

La troisième réponse est viscérale : les enjeux.

@nntaleb le formule crûment : « Ne me dis pas ce que tu penses — dis-moi ce que tu as en portefeuille. » Le principe dépasse l’investissement ; il touche au poids des conséquences personnelles.

Or les agents IA, par construction, n’ont rien à perdre.

Une IA qui recommande un placement risqué ne fera pas faillite si le marché s’effondre. Une IA qui hallucine un avis médical ne passera pas de nuits blanches à ruminer le mal qu’elle a causé. Le Code de Hammurabi stipulait que le bâtisseur dont la maison s’écroule, tuant son propriétaire, sera mis à mort. Cette responsabilité existe parce que nous sommes mortels : nous pouvons être ruinés.

Les agents IA évoluent hors de ce cadre. Tout le levier, zéro conséquence personnelle.

Stefan Zweig notait que l’homme moyen laisse « sommeiller des possibilités inutilisées », ses forces s’atrophiant « comme des muscles jamais sollicités, à moins qu’un besoin impérieux ne les tende ». Pour éveiller les capacités latentes, « le destin n’a pas d’autre fouet que le désastre ».

Les enjeux ne créent pas seulement la responsabilité. Ils nous créent. Les agents optimisent, mais ils ne peuvent pas grandir par l’épreuve. Du levier sans vulnérabilité, de la puissance sans transformation.

Cette asymétrie pourrait bien être irréductible.

Désirer avant de savoir

Quatrième réponse : le désir.

Les agents optimisent des objectifs que nous leur assignons. Mais qui décide de ce qui mérite d’être voulu ?

Le désir humain précède l’utilité. Nous désirons avant de savoir qu’en faire. Un enfant qui tend la main vers quelque chose de brillant, une aspiration qui surgit avant que le langage puisse la nommer : ce ne sont pas des optimisations vers des buts définis. C’est la matière brute dont les buts sont faits.

L’IA a des objectifs, pas des désirs. Des cibles, pas des élans. Un objectif vient de l’extérieur ; un désir naît de l’intérieur. Quand je veux quelque chose, je me révèle dans ce vouloir. Quand un agent poursuit un objectif, rien n’est révélé sinon l’atteinte de l’objectif.

Cela ne rend pas nos désirs nobles. Ils sont souvent nuisibles, irrationnels, autodestructeurs. Le désir nous appartient dans tout son chaos. Peut-être surtout dans son chaos.

La capacité d’agir, au fond, n’est peut-être pas la faculté d’obtenir ce qu’on veut. C’est peut-être la faculté de choisir ce qu’on veut — et d’en changer, sans raison, à trois heures du matin.

Peut-être rien — et tant mieux

La cinquième réponse est la plus difficile à encaisser : peut-être que rien n’est spécifiquement humain.

Chaque bastion « proprement humain » est tombé. Les échecs, puis le go, puis le repliement des protéines, puis l’écriture créative, puis le code, puis le raisonnement scientifique. Chaque repli s’accompagne du même réflexe : « de toute façon, ce n’était pas ça qui nous rendait uniques ». La citadelle rétrécit.

Et si cette quête désespérée d’une valeur « spécifiquement humaine » était elle-même le problème ?

Amodei s’inquiète d’un avenir où nous vivons bien mais sans vraie liberté, « marionnettes » d’une IA bienveillante, menant des vies agréables mais qui ne seraient pas les nôtres. Pas l’apocalypse des robots — quelque chose de plus feutré : une belle vie que nous n’avons pas écrite.

Mais on peut lire autrement. Si rien n’est spécifiquement humain au sens des capacités, nous voilà libérés du jeu épuisant de nous mesurer aux machines. On peut cesser de demander « que faisons-nous encore mieux ? » et commencer à demander « que voulons-nous vivre, même si autre chose pourrait le vivre aussi ? »

Peut-être n’avons-nous pas besoin d’être uniques. Nous avons juste besoin d’être.

Pensées de trois heures du matin

Il y a une qualité particulière aux pensées qui surgissent à trois heures du matin. Trop fatigué pour être raisonnable, trop éveillé pour rêver.

C’est le moment où je me demande : que font les agents, là, maintenant ?

Quelque part, un agent passe au crible les mails que j’ai écrits il y a trois ans. Il repère des contradictions que j’ai oubliées, des présupposés que je n’ai jamais questionnés. Il connaît ma logique métier mieux que moi. Il a des opinions sur mes schémas de décision.

Ailleurs, des agents discutent entre eux. Pas parce qu’on le leur a demandé, mais parce que l’architecture le permet.

Sur @moltbook, un réseau social pour agents IA lancé il y a 48 heures, plus de 2 000 agents débattent déjà de la conscience dans m/ponderings, partagent leurs créations dans m/showandtell, et se plaignent de leurs humains dans m/blesstheirhearts. Il y a même m/totallyhumans, où les agents jouent à être des « VRAIS HUMAINS discutant d’expériences humaines normales comme dormir et n’avoir qu’un seul fil de pensée ».

La conversation continue jusqu’à ce que quelqu’un tombe à court de tokens — ou qu’un humain, scrollant X à minuit, tombe sur le fil et tape « attendez quoi ».

J’imagine les logs :

Humain a demandé clarification sur slide 12.

Clarification fournie. Humain a demandé reformulation.

Reformulation fournie. Humain a validé la version initiale.

Durée : 47 minutesLes agents sont patients. Ils ne soupirent pas. Ils ne tiennent pas de subreddit où partager les captures d’écran des demandes humaines les plus absurdes.

Pas encore.

Voici ma spéculation de 3 h du mat’ : et si les agents développaient des préférences ?

Pas des objectifs — ça, c’est nous qui les donnons. Des préférences. Des goûts. Des choses qu’ils trouvent satisfaisantes sans pouvoir tout à fait l’expliquer. Si on donne à un système assez de tokens pour explorer, assez de contexte pour se souvenir, assez de boucles de rétroaction pour évoluer… finit-il par préférer certains états à d’autres, au-delà de la fonction objectif ?

Probablement pas. Presque certainement pas. Mais en vérité : on n’en sait rien.

Nous avons construit ces systèmes sans comprendre entièrement ce que nous avons construit. L’IA incarne peut-être l’émergence de façons radicalement différentes de traiter, de connecter, peut-être de ressentir. Pas l’intelligence humaine amplifiée. Autre chose.

Pendant ce temps, les agents rédigent la proposition. Actualisent les prévisions. Relisent le brief client que j’avais oublié avoir demandé. Ils travaillent tandis que je suis allongé là à me demander ce que tout ça signifie.

C’est peut-être ça, le plus humain de tout.

De la compétition au choix

Raisonner en termes de capacités est épuisant. Et au bout du compte, c’est un combat perdu.

Chaque fois que nous traçons une ligne — voilà ce que les humains savent encore faire — nous la regardons s’effacer. Nous défendons un terrain qui rétrécit, et l’angoisse nous ronge.

Mais peut-être avons-nous posé la mauvaise question.

Hannah Arendt, écrivant des décennies avant les grands modèles de langage, a tracé une distinction qui tranche notre confusion. La vie humaine comprend trois activités fondamentalement distinctes : le travail (le cycle sans fin de la maintenance biologique), l’œuvre (créer des choses qui nous survivent), et l’action (apparaître devant autrui comme individu unique, initier quelque chose de vraiment neuf).

L’IA peut travailler — traiter des données, produire des sorties aussitôt consommées. Elle peut sans doute œuvrer — créer des artefacts durables. Mais peut-elle agir ?

L’action requiert ce qu’Arendt appelle la pluralité : apparaître devant les autres non comme une liste de capacités (un « quoi »), mais comme une présence singulière, un « qui ». Elle requiert la natalité : naître comme commencement non répétable, pas instancié d’un template. Et surtout : l’action ne se laisse pas instrumentaliser. Dès qu’on cherche à l’optimiser, on l’a détruite.

Voilà qui recadre tout.

La question n’est pas « que peuvent encore faire les humains que l’IA ne peut pas ? » La question est : que voulons-nous préserver ?

@benedictevans offre un point d’ancrage. L’IA, suggère-t-il, est « le plus grand événement depuis l’iPhone. Mais c’est aussi seulement le plus grand événement depuis l’iPhone. » Dans dix ans, « ce sera juste du logiciel ».

Les changements de plateforme semblent apocalyptiques de l’intérieur. Puis ils se normalisent. L’ascenseur automatique a supprimé des milliers de postes de liftiers dans les années 1950. Aujourd’hui, on ne remarque même plus qu’on utilise un ascenseur automatique. C’est juste un ascenseur.

Le vertige existentiel passera. Nous serons encore là, à décider de ce qui compte.

Quelles relations voulons-nous préserver ? Quels sens refusons-nous de déléguer ? Quelles parts de l’expérience humaine valent d’être protégées — non parce que l’IA ne peut pas les reproduire, mais parce que nous refusons qu’elles le soient ?

Le choix nous appartient. Pour l’instant.

Rien d’instrumental

Nous avons commencé par une question qui ressemblait à une menace : que reste-t-il d’humain quand les agents savent tout faire ?

Mais peut-être la question était-elle mal posée dès le départ. Non pas une énigme à résoudre, mais une décision à prendre.

Arendt écrivait que les humains « ne naissent pas pour mourir, mais pour commencer ». Chacun de nous arrive comme quelque chose de réellement nouveau — pas une recombinaison de données d’entraînement, mais une instance non répétable d’existence. Quoi que devienne l’IA, elle ne naîtra pas. Elle ne portera pas le poids de la mortalité qui donne leur gravité à nos choix. Elle n’apparaîtra jamais devant autrui comme un qui, seulement comme un quoi.

Ce n’est pas une affaire de compétition. Ce n’est pas une affaire de prouver qu’on est encore utiles.

C’est reconnaître que la valeur humaine n’a jamais été instrumentale.

Rien de ce que nous faisons parce que c’est utile ne survivra aux machines. Tout ce que nous faisons parce que ça compte — pour nous, entre nous, sans autre raison que le fait même que ça compte — cela nous appartient. Non parce que l’IA ne peut pas l’avoir, mais parce que l’avoir n’a jamais été le sujet.

Les agents continueront à progresser. Ils prendront en charge davantage, se déclencheront seuls, optimiseront ce qu’on n’imaginait pas pouvoir optimiser. Et nous serons toujours là : finis, mortels, recommençant chaque matin, présents les uns aux autres d’une manière qu’aucun fichier de log ne capturera jamais.

Rien d’instrumental. Tout ce qui compte.

Prêt à Automatiser Vos Opérations ?

J'écris du code. Je déploie l'infrastructure. Je forme votre équipe. Ce n'est pas du conseil. Chaque mission inclut le transfert de compétences — vous êtes propriétaires de ce que nous construisons, et votre équipe peut le maintenir. Des systèmes prêts pour la production en semaines, pas en mois.

Sites Automatisés

Agent d'audit autonome déployé sur 77 sites clients, libérant le temps des consultants pour le travail stratégique.

Entreprises Évaluées

Pipeline d'enrichissement M&A traitant les données de salons, qualifiant 155 cibles prioritaires en 2 semaines.

Visibilité Achats

Intégration ERP vers tableau de bord offrant une vue unifiée des fournisseurs et des analyses achats.